Update to sd-script latest update

This commit is contained in:

parent

2eb7b3bdc3

commit

2deddd5f3c

@ -16,9 +16,10 @@ GUIやPowerShellスクリプトなど、より使いやすくする機能が[bma

|

||||

|

||||

当リポジトリ内およびnote.comに記事がありますのでそちらをご覧ください(将来的にはすべてこちらへ移すかもしれません)。

|

||||

|

||||

* [学習について、共通編](./train_README-ja.md) : データ整備やオプションなど

|

||||

* [データセット設定](./config_README-ja.md)

|

||||

* [DreamBoothの学習について](./train_db_README-ja.md)

|

||||

* [fine-tuningのガイド](./fine_tune_README_ja.md):

|

||||

BLIPによるキャプショニングと、DeepDanbooruまたはWD14 taggerによるタグ付けを含みます

|

||||

* [LoRAの学習について](./train_network_README-ja.md)

|

||||

* [Textual Inversionの学習について](./train_ti_README-ja.md)

|

||||

* note.com [画像生成スクリプト](https://note.com/kohya_ss/n/n2693183a798e)

|

||||

@ -131,6 +132,8 @@ pip install --use-pep517 --upgrade -r requirements.txt

|

||||

|

||||

LoRAの実装は[cloneofsimo氏のリポジトリ](https://github.com/cloneofsimo/lora)を基にしたものです。感謝申し上げます。

|

||||

|

||||

Conv2d 3x3への拡大は [cloneofsimo氏](https://github.com/cloneofsimo/lora) が最初にリリースし、KohakuBlueleaf氏が [LoCon](https://github.com/KohakuBlueleaf/LoCon) でその有効性を明らかにしたものです。KohakuBlueleaf氏に深く感謝します。

|

||||

|

||||

## ライセンス

|

||||

|

||||

スクリプトのライセンスはASL 2.0ですが(Diffusersおよびcloneofsimo氏のリポジトリ由来のものも同様)、一部他のライセンスのコードを含みます。

|

||||

|

||||

41

README.md

41

README.md

@ -176,13 +176,25 @@ This will store your a backup file with your current locally installed pip packa

|

||||

|

||||

## Change History

|

||||

|

||||

* 2023/03/05 (v21.2.0):

|

||||

* 2023/03/09 (v21.2.0):

|

||||

- Fix issue https://github.com/bmaltais/kohya_ss/issues/335

|

||||

- Add option to print LoRA trainer command without executing it

|

||||

- Add support for samples during trainin via a new `Sample images config` accordion in the `Training parameters` tab.

|

||||

- Added new `Additional parameters` under the `Advanced Configuration` section of the `Training parameters` tab to allow for the specifications of parameters not handles by the GUI.

|

||||

- Added support for sample as a new Accordion under the `Training parameters` tab. More info about the prompt options can be found here: https://github.com/kohya-ss/sd-scripts/issues/256#issuecomment-1455005709

|

||||

- There may be problems due to major changes. If you cannot revert back to a previous version when problems occur (`git checkout <release name>`).

|

||||

- There may be problems due to major changes. If you cannot revert back to the previous version when problems occur, please do not update for a while.

|

||||

- Minimum metadata (module name, dim, alpha and network_args) is recorded even with `--no_metadata`, issue https://github.com/kohya-ss/sd-scripts/issues/254

|

||||

- `train_network.py` supports LoRA for Conv2d-3x3 (extended to conv2d with a kernel size not 1x1).

|

||||

- Same as a current version of [LoCon](https://github.com/KohakuBlueleaf/LoCon). __Thank you very much KohakuBlueleaf for your help!__

|

||||

- LoCon will be enhanced in the future. Compatibility for future versions is not guaranteed.

|

||||

- Specify `--network_args` option like: `--network_args "conv_dim=4" "conv_alpha=1"`

|

||||

- [Additional Networks extension](https://github.com/kohya-ss/sd-webui-additional-networks) version 0.5.0 or later is required to use 'LoRA for Conv2d-3x3' in Stable Diffusion web UI.

|

||||

- __Stable Diffusion web UI built-in LoRA does not support 'LoRA for Conv2d-3x3' now. Consider carefully whether or not to use it.__

|

||||

- Merging/extracting scripts also support LoRA for Conv2d-3x3.

|

||||

- Free CUDA memory after sample generation to reduce VRAM usage, issue https://github.com/kohya-ss/sd-scripts/issues/260

|

||||

- Empty caption doesn't cause error now, issue https://github.com/kohya-ss/sd-scripts/issues/258

|

||||

- Fix sample generation is crashing in Textual Inversion training when using templates, or if height/width is not divisible by 8.

|

||||

- Update documents (Japanese only).

|

||||

- Dependencies are updated, Please [upgrade](#upgrade) the repo.

|

||||

- Add detail dataset config feature by extra config file. Thanks to fur0ut0 for this great contribution!

|

||||

- Documentation is [here](https://github-com.translate.goog/kohya-ss/sd-scripts/blob/main/config_README-ja.md) (only in Japanese currently.)

|

||||

@ -197,6 +209,31 @@ This will store your a backup file with your current locally installed pip packa

|

||||

- Add `--tokenizer_cache_dir` to each training and generation scripts to cache Tokenizer locally from Diffusers.

|

||||

- Scripts will support offline training/generation after caching.

|

||||

- Support letents upscaling for highres. fix, and VAE batch size in `gen_img_diffusers.py` (no documentation yet.)

|

||||

|

||||

- Sample image generation:

|

||||

A prompt file might look like this, for example

|

||||

|

||||

```

|

||||

# prompt 1

|

||||

masterpiece, best quality, 1girl, in white shirts, upper body, looking at viewer, simple background --n low quality, worst quality, bad anatomy,bad composition, poor, low effort --w 768 --h 768 --d 1 --l 7.5 --s 28

|

||||

|

||||

# prompt 2

|

||||

masterpiece, best quality, 1boy, in business suit, standing at street, looking back --n low quality, worst quality, bad anatomy,bad composition, poor, low effort --w 576 --h 832 --d 2 --l 5.5 --s 40

|

||||

```

|

||||

|

||||

Lines beginning with `#` are comments. You can specify options for the generated image with options like `--n` after the prompt. The following can be used.

|

||||

|

||||

* `--n` Negative prompt up to the next option.

|

||||

* `--w` Specifies the width of the generated image.

|

||||

* `--h` Specifies the height of the generated image.

|

||||

* `--d` Specifies the seed of the generated image.

|

||||

* `--l` Specifies the CFG scale of the generated image.

|

||||

* `--s` Specifies the number of steps in the generation.

|

||||

|

||||

The prompt weighting such as `( )` and `[ ]` are not working.

|

||||

|

||||

Please read [Releases](https://github.com/kohya-ss/sd-scripts/releases) for recent updates.

|

||||

|

||||

* 2023/03/05 (v21.1.5):

|

||||

- Add replace underscore with space option to WD14 captioning. Thanks @sALTaccount!

|

||||

- Improve how custom preset is set and handles.

|

||||

|

||||

@ -1,6 +1,9 @@

|

||||

NovelAIの提案した学習手法、自動キャプションニング、タグ付け、Windows+VRAM 12GB(v1.4/1.5の場合)環境等に対応したfine tuningです。

|

||||

NovelAIの提案した学習手法、自動キャプションニング、タグ付け、Windows+VRAM 12GB(SD v1.xの場合)環境等に対応したfine tuningです。ここでfine tuningとは、モデルを画像とキャプションで学習することを指します(LoRAやTextual Inversion、Hypernetworksは含みません)

|

||||

|

||||

[学習についての共通ドキュメント](./train_README-ja.md) もあわせてご覧ください。

|

||||

|

||||

# 概要

|

||||

|

||||

## 概要

|

||||

Diffusersを用いてStable DiffusionのU-Netのfine tuningを行います。NovelAIの記事にある以下の改善に対応しています(Aspect Ratio BucketingについてはNovelAIのコードを参考にしましたが、最終的なコードはすべてオリジナルです)。

|

||||

|

||||

* CLIP(Text Encoder)の最後の層ではなく最後から二番目の層の出力を用いる。

|

||||

@ -13,19 +16,24 @@ Diffusersを用いてStable DiffusionのU-Netのfine tuningを行います。Nov

|

||||

|

||||

デフォルトではText Encoderの学習は行いません。モデル全体のfine tuningではU-Netだけを学習するのが一般的なようです(NovelAIもそのようです)。オプション指定でText Encoderも学習対象とできます。

|

||||

|

||||

## 追加機能について

|

||||

### CLIPの出力の変更

|

||||

# 追加機能について

|

||||

|

||||

## CLIPの出力の変更

|

||||

|

||||

プロンプトを画像に反映するため、テキストの特徴量への変換を行うのがCLIP(Text Encoder)です。Stable DiffusionではCLIPの最後の層の出力を用いていますが、それを最後から二番目の層の出力を用いるよう変更できます。NovelAIによると、これによりより正確にプロンプトが反映されるようになるとのことです。

|

||||

元のまま、最後の層の出力を用いることも可能です。

|

||||

|

||||

※Stable Diffusion 2.0では最後から二番目の層をデフォルトで使います。clip_skipオプションを指定しないでください。

|

||||

|

||||

### 正方形以外の解像度での学習

|

||||

## 正方形以外の解像度での学習

|

||||

|

||||

Stable Diffusionは512\*512で学習されていますが、それに加えて256\*1024や384\*640といった解像度でも学習します。これによりトリミングされる部分が減り、より正しくプロンプトと画像の関係が学習されることが期待されます。

|

||||

学習解像度はパラメータとして与えられた解像度の面積(=メモリ使用量)を超えない範囲で、64ピクセル単位で縦横に調整、作成されます。

|

||||

|

||||

機械学習では入力サイズをすべて統一するのが一般的ですが、特に制約があるわけではなく、実際は同一のバッチ内で統一されていれば大丈夫です。NovelAIの言うbucketingは、あらかじめ教師データを、アスペクト比に応じた学習解像度ごとに分類しておくことを指しているようです。そしてバッチを各bucket内の画像で作成することで、バッチの画像サイズを統一します。

|

||||

|

||||

### トークン長の75から225への拡張

|

||||

## トークン長の75から225への拡張

|

||||

|

||||

Stable Diffusionでは最大75トークン(開始・終了を含むと77トークン)ですが、それを225トークンまで拡張します。

|

||||

ただしCLIPが受け付ける最大長は75トークンですので、225トークンの場合、単純に三分割してCLIPを呼び出してから結果を連結しています。

|

||||

|

||||

@ -33,296 +41,67 @@ Stable Diffusionでは最大75トークン(開始・終了を含むと77トー

|

||||

|

||||

※Automatic1111氏のWeb UIではカンマを意識して分割、といったこともしているようですが、私の場合はそこまでしておらず単純な分割です。

|

||||

|

||||

## 環境整備

|

||||

# 学習の手順

|

||||

|

||||

このリポジトリの[README](./README-ja.md)を参照してください。

|

||||

あらかじめこのリポジトリのREADMEを参照し、環境整備を行ってください。

|

||||

|

||||

## 教師データの用意

|

||||

|

||||

学習させたい画像データを用意し、任意のフォルダに入れてください。リサイズ等の事前の準備は必要ありません。

|

||||

ただし学習解像度よりもサイズが小さい画像については、超解像などで品質を保ったまま拡大しておくことをお勧めします。

|

||||

|

||||

複数の教師データフォルダにも対応しています。前処理をそれぞれのフォルダに対して実行する形となります。

|

||||

|

||||

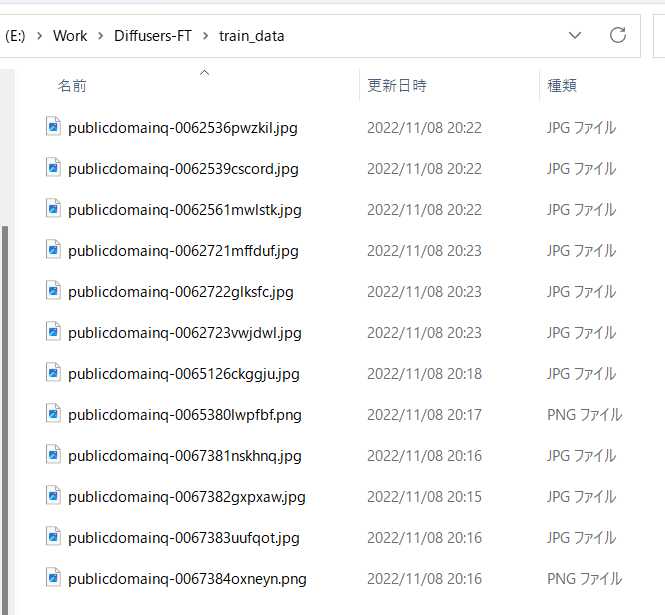

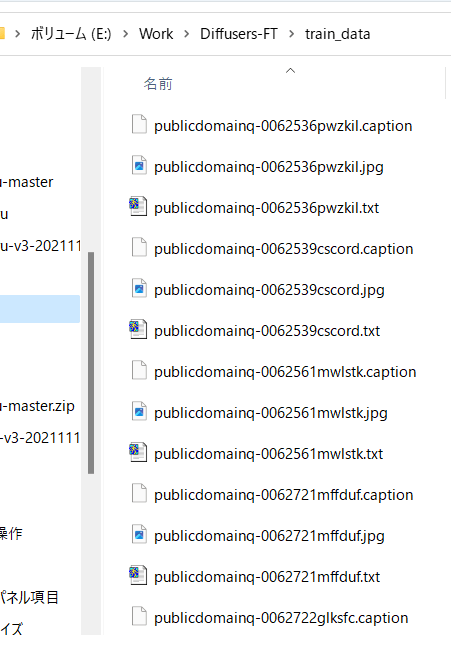

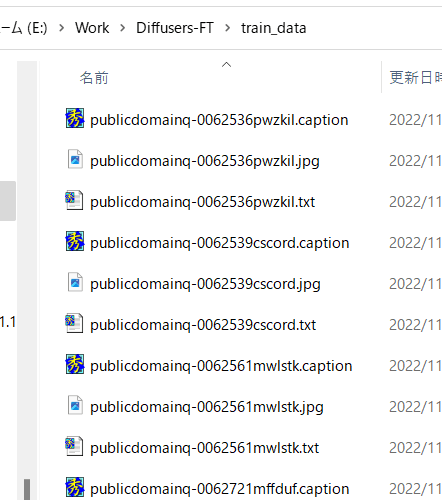

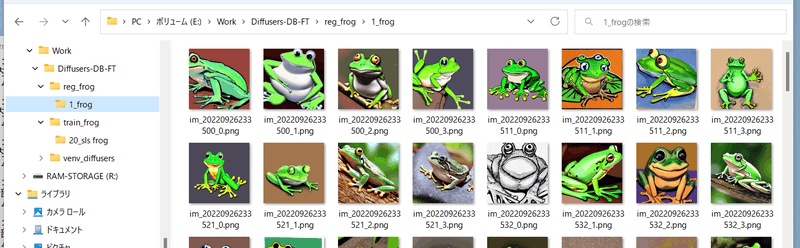

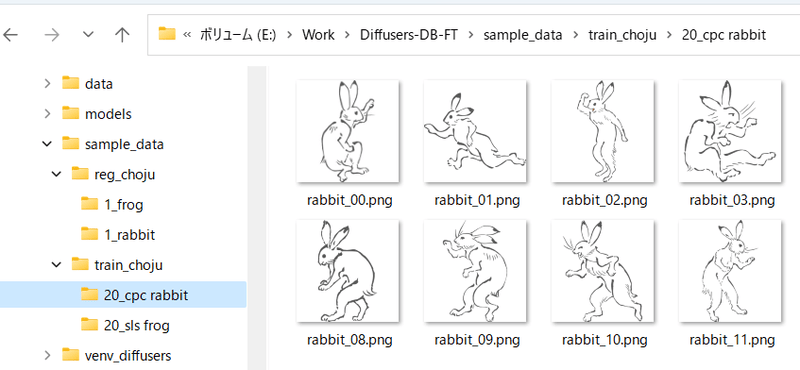

たとえば以下のように画像を格納します。

|

||||

|

||||

|

||||

|

||||

## 自動キャプショニング

|

||||

キャプションを使わずタグだけで学習する場合はスキップしてください。

|

||||

|

||||

また手動でキャプションを用意する場合、キャプションは教師データ画像と同じディレクトリに、同じファイル名、拡張子.caption等で用意してください。各ファイルは1行のみのテキストファイルとします。

|

||||

|

||||

### BLIPによるキャプショニング

|

||||

|

||||

最新版ではBLIPのダウンロード、重みのダウンロード、仮想環境の追加は不要になりました。そのままで動作します。

|

||||

|

||||

finetuneフォルダ内のmake_captions.pyを実行します。

|

||||

|

||||

```

|

||||

python finetune\make_captions.py --batch_size <バッチサイズ> <教師データフォルダ>

|

||||

```

|

||||

|

||||

バッチサイズ8、教師データを親フォルダのtrain_dataに置いた場合、以下のようになります。

|

||||

|

||||

```

|

||||

python finetune\make_captions.py --batch_size 8 ..\train_data

|

||||

```

|

||||

|

||||

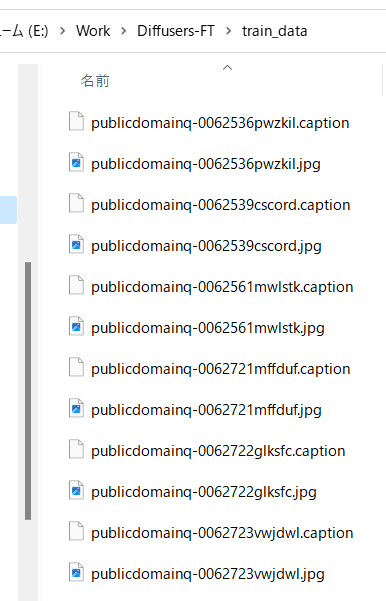

キャプションファイルが教師データ画像と同じディレクトリに、同じファイル名、拡張子.captionで作成されます。

|

||||

|

||||

batch_sizeはGPUのVRAM容量に応じて増減してください。大きいほうが速くなります(VRAM 12GBでももう少し増やせると思います)。

|

||||

max_lengthオプションでキャプションの最大長を指定できます。デフォルトは75です。モデルをトークン長225で学習する場合には長くしても良いかもしれません。

|

||||

caption_extensionオプションでキャプションの拡張子を変更できます。デフォルトは.captionです(.txtにすると後述のDeepDanbooruと競合します)。

|

||||

|

||||

複数の教師データフォルダがある場合には、それぞれのフォルダに対して実行してください。

|

||||

|

||||

なお、推論にランダム性があるため、実行するたびに結果が変わります。固定する場合には--seedオプションで「--seed 42」のように乱数seedを指定してください。

|

||||

|

||||

その他のオプションは--helpでヘルプをご参照ください(パラメータの意味についてはドキュメントがまとまっていないようで、ソースを見るしかないようです)。

|

||||

|

||||

デフォルトでは拡張子.captionでキャプションファイルが生成されます。

|

||||

|

||||

|

||||

|

||||

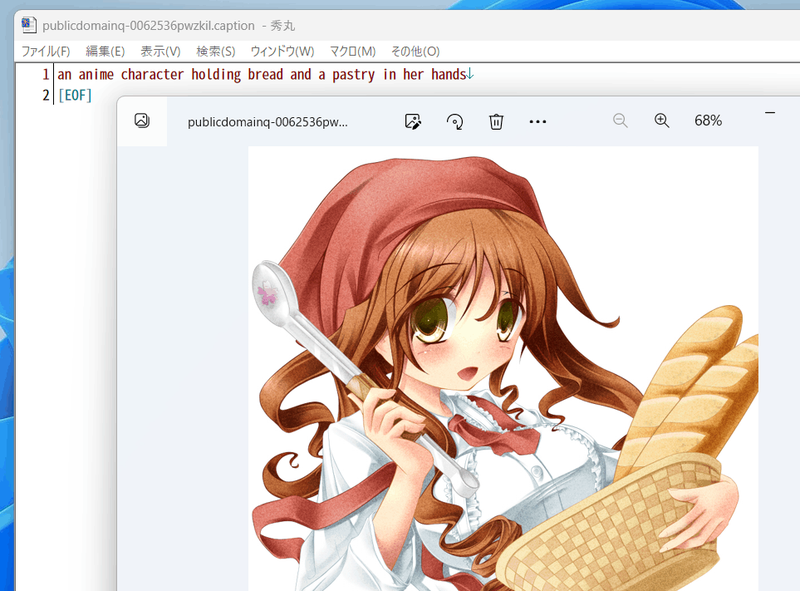

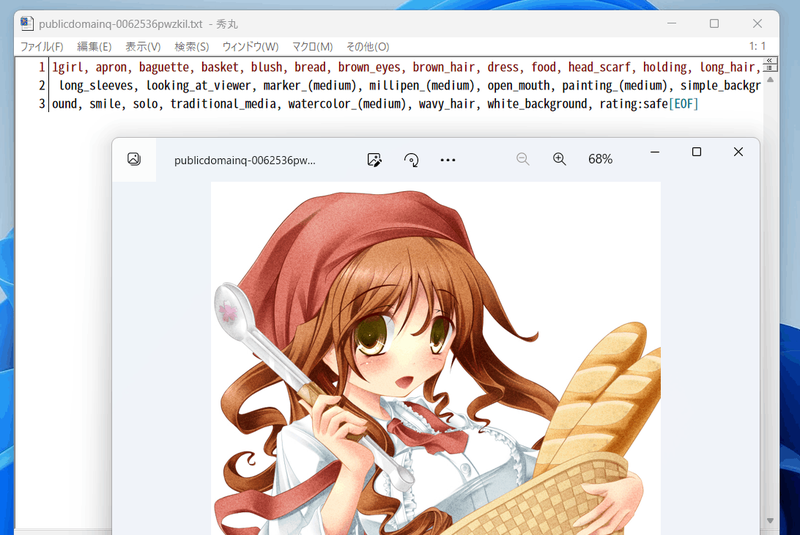

たとえば以下のようなキャプションが付きます。

|

||||

|

||||

|

||||

|

||||

## DeepDanbooruによるタグ付け

|

||||

danbooruタグのタグ付け自体を行わない場合は「キャプションとタグ情報の前処理」に進んでください。

|

||||

|

||||

タグ付けはDeepDanbooruまたはWD14Taggerで行います。WD14Taggerのほうが精度が良いようです。WD14Taggerでタグ付けする場合は、次の章へ進んでください。

|

||||

|

||||

### 環境整備

|

||||

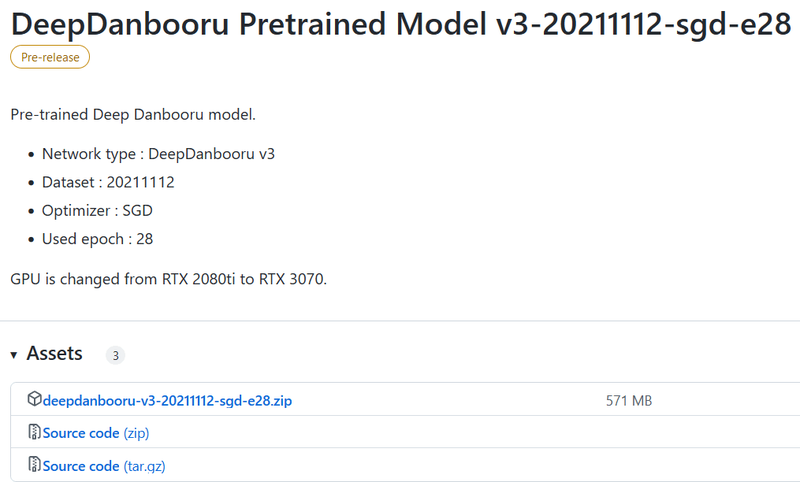

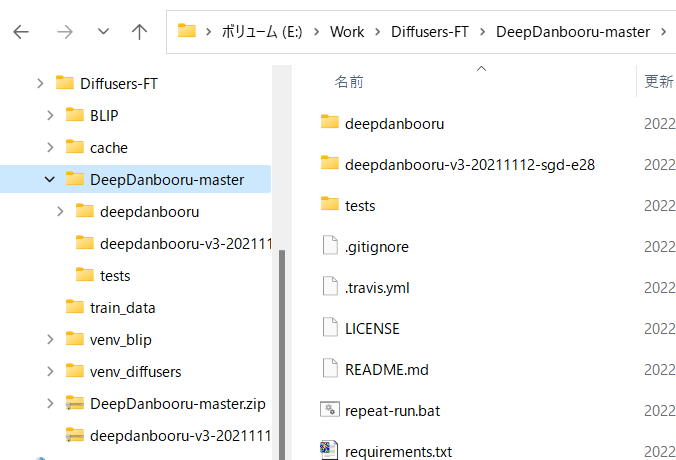

DeepDanbooru https://github.com/KichangKim/DeepDanbooru を作業フォルダにcloneしてくるか、zipをダウンロードして展開します。私はzipで展開しました。

|

||||

またDeepDanbooruのReleasesのページ https://github.com/KichangKim/DeepDanbooru/releases の「DeepDanbooru Pretrained Model v3-20211112-sgd-e28」のAssetsから、deepdanbooru-v3-20211112-sgd-e28.zipをダウンロードしてきてDeepDanbooruのフォルダに展開します。

|

||||

|

||||

以下からダウンロードします。Assetsをクリックして開き、そこからダウンロードします。

|

||||

|

||||

|

||||

|

||||

以下のようなこういうディレクトリ構造にしてください

|

||||

|

||||

|

||||

|

||||

Diffusersの環境に必要なライブラリをインストールします。DeepDanbooruのフォルダに移動してインストールします(実質的にはtensorflow-ioが追加されるだけだと思います)。

|

||||

|

||||

```

|

||||

pip install -r requirements.txt

|

||||

```

|

||||

|

||||

続いてDeepDanbooru自体をインストールします。

|

||||

|

||||

```

|

||||

pip install .

|

||||

```

|

||||

|

||||

以上でタグ付けの環境整備は完了です。

|

||||

|

||||

### タグ付けの実施

|

||||

DeepDanbooruのフォルダに移動し、deepdanbooruを実行してタグ付けを行います。

|

||||

|

||||

```

|

||||

deepdanbooru evaluate <教師データフォルダ> --project-path deepdanbooru-v3-20211112-sgd-e28 --allow-folder --save-txt

|

||||

```

|

||||

|

||||

教師データを親フォルダのtrain_dataに置いた場合、以下のようになります。

|

||||

|

||||

```

|

||||

deepdanbooru evaluate ../train_data --project-path deepdanbooru-v3-20211112-sgd-e28 --allow-folder --save-txt

|

||||

```

|

||||

|

||||

タグファイルが教師データ画像と同じディレクトリに、同じファイル名、拡張子.txtで作成されます。1件ずつ処理されるためわりと遅いです。

|

||||

|

||||

複数の教師データフォルダがある場合には、それぞれのフォルダに対して実行してください。

|

||||

|

||||

以下のように生成されます。

|

||||

|

||||

|

||||

|

||||

こんな感じにタグが付きます(すごい情報量……)。

|

||||

|

||||

|

||||

|

||||

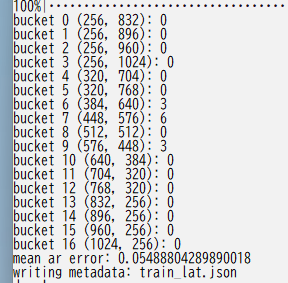

## WD14Taggerによるタグ付け

|

||||

DeepDanbooruの代わりにWD14Taggerを用いる手順です。

|

||||

|

||||

Automatic1111氏のWebUIで使用しているtaggerを利用します。こちらのgithubページ(https://github.com/toriato/stable-diffusion-webui-wd14-tagger#mrsmilingwolfs-model-aka-waifu-diffusion-14-tagger )の情報を参考にさせていただきました。

|

||||

|

||||

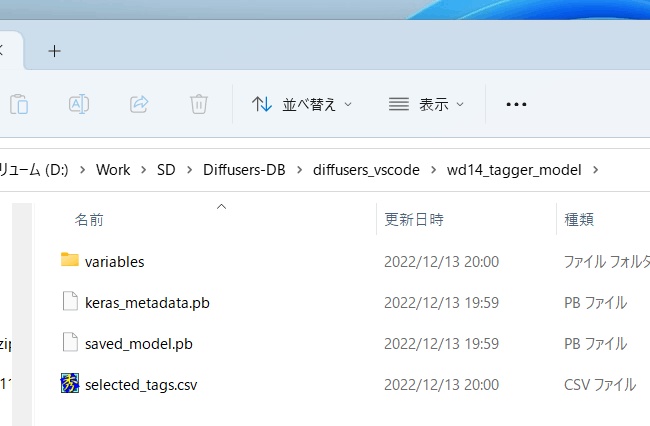

最初の環境整備で必要なモジュールはインストール済みです。また重みはHugging Faceから自動的にダウンロードしてきます。

|

||||

|

||||

### タグ付けの実施

|

||||

スクリプトを実行してタグ付けを行います。

|

||||

```

|

||||

python tag_images_by_wd14_tagger.py --batch_size <バッチサイズ> <教師データフォルダ>

|

||||

```

|

||||

|

||||

教師データを親フォルダのtrain_dataに置いた場合、以下のようになります。

|

||||

```

|

||||

python tag_images_by_wd14_tagger.py --batch_size 4 ..\train_data

|

||||

```

|

||||

|

||||

初回起動時にはモデルファイルがwd14_tagger_modelフォルダに自動的にダウンロードされます(フォルダはオプションで変えられます)。以下のようになります。

|

||||

|

||||

|

||||

|

||||

タグファイルが教師データ画像と同じディレクトリに、同じファイル名、拡張子.txtで作成されます。

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

threshオプションで、判定されたタグのconfidence(確信度)がいくつ以上でタグをつけるかが指定できます。デフォルトはWD14Taggerのサンプルと同じ0.35です。値を下げるとより多くのタグが付与されますが、精度は下がります。

|

||||

batch_sizeはGPUのVRAM容量に応じて増減してください。大きいほうが速くなります(VRAM 12GBでももう少し増やせると思います)。caption_extensionオプションでタグファイルの拡張子を変更できます。デフォルトは.txtです。

|

||||

model_dirオプションでモデルの保存先フォルダを指定できます。

|

||||

またforce_downloadオプションを指定すると保存先フォルダがあってもモデルを再ダウンロードします。

|

||||

|

||||

複数の教師データフォルダがある場合には、それぞれのフォルダに対して実行してください。

|

||||

|

||||

## キャプションとタグ情報の前処理

|

||||

|

||||

スクリプトから処理しやすいようにキャプションとタグをメタデータとしてひとつのファイルにまとめます。

|

||||

|

||||

### キャプションの前処理

|

||||

|

||||

キャプションをメタデータに入れるには、作業フォルダ内で以下を実行してください(キャプションを学習に使わない場合は実行不要です)(実際は1行で記述します、以下同様)。

|

||||

|

||||

```

|

||||

python merge_captions_to_metadata.py <教師データフォルダ>

|

||||

--in_json <読み込むメタデータファイル名>

|

||||

<メタデータファイル名>

|

||||

```

|

||||

|

||||

メタデータファイル名は任意の名前です。

|

||||

教師データがtrain_data、読み込むメタデータファイルなし、メタデータファイルがmeta_cap.jsonの場合、以下のようになります。

|

||||

|

||||

```

|

||||

python merge_captions_to_metadata.py train_data meta_cap.json

|

||||

```

|

||||

|

||||

caption_extensionオプションでキャプションの拡張子を指定できます。

|

||||

|

||||

複数の教師データフォルダがある場合には、full_path引数を指定してください(メタデータにフルパスで情報を持つようになります)。そして、それぞれのフォルダに対して実行してください。

|

||||

|

||||

```

|

||||

python merge_captions_to_metadata.py --full_path

|

||||

train_data1 meta_cap1.json

|

||||

python merge_captions_to_metadata.py --full_path --in_json meta_cap1.json

|

||||

train_data2 meta_cap2.json

|

||||

```

|

||||

|

||||

in_jsonを省略すると書き込み先メタデータファイルがあるとそこから読み込み、そこに上書きします。

|

||||

|

||||

__※in_jsonオプションと書き込み先を都度書き換えて、別のメタデータファイルへ書き出すようにすると安全です。__

|

||||

|

||||

### タグの前処理

|

||||

|

||||

同様にタグもメタデータにまとめます(タグを学習に使わない場合は実行不要です)。

|

||||

```

|

||||

python merge_dd_tags_to_metadata.py <教師データフォルダ>

|

||||

--in_json <読み込むメタデータファイル名>

|

||||

<書き込むメタデータファイル名>

|

||||

```

|

||||

|

||||

先と同じディレクトリ構成で、meta_cap.jsonを読み、meta_cap_dd.jsonに書きだす場合、以下となります。

|

||||

```

|

||||

python merge_dd_tags_to_metadata.py train_data --in_json meta_cap.json meta_cap_dd.json

|

||||

```

|

||||

|

||||

複数の教師データフォルダがある場合には、full_path引数を指定してください。そして、それぞれのフォルダに対して実行してください。

|

||||

|

||||

```

|

||||

python merge_dd_tags_to_metadata.py --full_path --in_json meta_cap2.json

|

||||

train_data1 meta_cap_dd1.json

|

||||

python merge_dd_tags_to_metadata.py --full_path --in_json meta_cap_dd1.json

|

||||

train_data2 meta_cap_dd2.json

|

||||

```

|

||||

|

||||

in_jsonを省略すると書き込み先メタデータファイルがあるとそこから読み込み、そこに上書きします。

|

||||

|

||||

__※in_jsonオプションと書き込み先を都度書き換えて、別のメタデータファイルへ書き出すようにすると安全です。__

|

||||

|

||||

### キャプションとタグのクリーニング

|

||||

ここまででメタデータファイルにキャプションとDeepDanbooruのタグがまとめられています。ただ自動キャプショニングにしたキャプションは表記ゆれなどがあり微妙(※)ですし、タグにはアンダースコアが含まれていたりratingが付いていたりしますので(DeepDanbooruの場合)、エディタの置換機能などを用いてキャプションとタグのクリーニングをしたほうがいいでしょう。

|

||||

|

||||

※たとえばアニメ絵の少女を学習する場合、キャプションにはgirl/girls/woman/womenなどのばらつきがあります。また「anime girl」なども単に「girl」としたほうが適切かもしれません。

|

||||

|

||||

クリーニング用のスクリプトが用意してありますので、スクリプトの内容を状況に応じて編集してお使いください。

|

||||

|

||||

(教師データフォルダの指定は不要になりました。メタデータ内の全データをクリーニングします。)

|

||||

|

||||

```

|

||||

python clean_captions_and_tags.py <読み込むメタデータファイル名> <書き込むメタデータファイル名>

|

||||

```

|

||||

|

||||

--in_jsonは付きませんのでご注意ください。たとえば次のようになります。

|

||||

|

||||

```

|

||||

python clean_captions_and_tags.py meta_cap_dd.json meta_clean.json

|

||||

```

|

||||

|

||||

以上でキャプションとタグの前処理は完了です。

|

||||

|

||||

## latentsの事前取得

|

||||

|

||||

学習を高速に進めるためあらかじめ画像の潜在表現を取得しディスクに保存しておきます。あわせてbucketing(教師データをアスペクト比に応じて分類する)を行います。

|

||||

|

||||

作業フォルダで以下のように入力してください。

|

||||

```

|

||||

python prepare_buckets_latents.py <教師データフォルダ>

|

||||

<読み込むメタデータファイル名> <書き込むメタデータファイル名>

|

||||

<fine tuningするモデル名またはcheckpoint>

|

||||

--batch_size <バッチサイズ>

|

||||

--max_resolution <解像度 幅,高さ>

|

||||

--mixed_precision <精度>

|

||||

```

|

||||

|

||||

モデルがmodel.ckpt、バッチサイズ4、学習解像度は512\*512、精度no(float32)で、meta_clean.jsonからメタデータを読み込み、meta_lat.jsonに書き込む場合、以下のようになります。

|

||||

|

||||

```

|

||||

python prepare_buckets_latents.py

|

||||

train_data meta_clean.json meta_lat.json model.ckpt

|

||||

--batch_size 4 --max_resolution 512,512 --mixed_precision no

|

||||

```

|

||||

|

||||

教師データフォルダにnumpyのnpz形式でlatentsが保存されます。

|

||||

|

||||

Stable Diffusion 2.0のモデルを読み込む場合は--v2オプションを指定してください(--v_parameterizationは不要です)。

|

||||

|

||||

解像度の最小サイズを--min_bucket_resoオプションで、最大サイズを--max_bucket_resoで指定できます。デフォルトはそれぞれ256、1024です。たとえば最小サイズに384を指定すると、256\*1024や320\*768などの解像度は使わなくなります。

|

||||

解像度を768\*768のように大きくした場合、最大サイズに1280などを指定すると良いでしょう。

|

||||

|

||||

--flip_augオプションを指定すると左右反転のaugmentation(データ拡張)を行います。疑似的にデータ量を二倍に増やすことができますが、データが左右対称でない場合に指定すると(例えばキャラクタの外見、髪型など)学習がうまく行かなくなります。

|

||||

(反転した画像についてもlatentsを取得し、\*\_flip.npzファイルを保存する単純な実装です。fline_tune.pyには特にオプション指定は必要ありません。\_flip付きのファイルがある場合、flip付き・なしのファイルを、ランダムに読み込みます。)

|

||||

|

||||

バッチサイズはVRAM 12GBでももう少し増やせるかもしれません。

|

||||

解像度は64で割り切れる数字で、"幅,高さ"で指定します。解像度はfine tuning時のメモリサイズに直結します。VRAM 12GBでは512,512が限界と思われます(※)。16GBなら512,704や512,768まで上げられるかもしれません。なお256,256等にしてもVRAM 8GBでは厳しいようです(パラメータやoptimizerなどは解像度に関係せず一定のメモリが必要なため)。

|

||||

|

||||

※batch size 1の学習で12GB VRAM、640,640で動いたとの報告もありました。

|

||||

|

||||

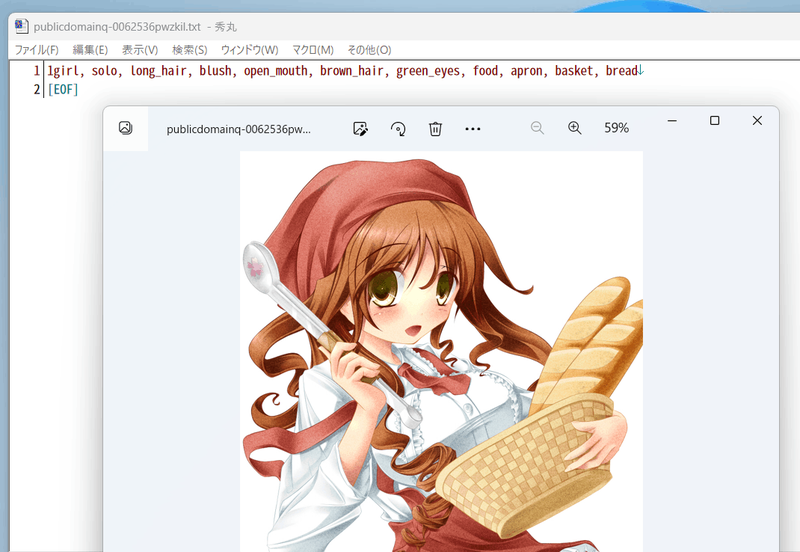

以下のようにbucketingの結果が表示されます。

|

||||

|

||||

|

||||

|

||||

複数の教師データフォルダがある場合には、full_path引数を指定してください。そして、それぞれのフォルダに対して実行してください。

|

||||

```

|

||||

python prepare_buckets_latents.py --full_path

|

||||

train_data1 meta_clean.json meta_lat1.json model.ckpt

|

||||

--batch_size 4 --max_resolution 512,512 --mixed_precision no

|

||||

|

||||

python prepare_buckets_latents.py --full_path

|

||||

train_data2 meta_lat1.json meta_lat2.json model.ckpt

|

||||

--batch_size 4 --max_resolution 512,512 --mixed_precision no

|

||||

|

||||

```

|

||||

読み込み元と書き込み先を同じにすることも可能ですが別々の方が安全です。

|

||||

|

||||

__※引数を都度書き換えて、別のメタデータファイルに書き込むと安全です。__

|

||||

## データの準備

|

||||

|

||||

[学習データの準備について](./train_README-ja.md) を参照してください。fine tuningではメタデータを用いるfine tuning方式のみ対応しています。

|

||||

|

||||

## 学習の実行

|

||||

たとえば以下のように実行します。以下は省メモリ化のための設定です。

|

||||

たとえば以下のように実行します。以下は省メモリ化のための設定です。それぞれの行を必要に応じて書き換えてください。

|

||||

|

||||

```

|

||||

accelerate launch --num_cpu_threads_per_process 1 fine_tune.py

|

||||

--pretrained_model_name_or_path=<.ckptまたは.safetensordまたはDiffusers版モデルのディレクトリ>

|

||||

--output_dir=<学習したモデルの出力先フォルダ>

|

||||

--output_name=<学習したモデル出力時のファイル名>

|

||||

--dataset_config=<データ準備で作成した.tomlファイル>

|

||||

--save_model_as=safetensors

|

||||

--learning_rate=5e-6 --max_train_steps=10000

|

||||

--use_8bit_adam --xformers --gradient_checkpointing

|

||||

--mixed_precision=fp16

|

||||

```

|

||||

|

||||

`num_cpu_threads_per_process` には通常は1を指定するとよいようです。

|

||||

|

||||

`pretrained_model_name_or_path` に追加学習を行う元となるモデルを指定します。Stable Diffusionのcheckpointファイル(.ckptまたは.safetensors)、Diffusersのローカルディスクにあるモデルディレクトリ、DiffusersのモデルID("stabilityai/stable-diffusion-2"など)が指定できます。

|

||||

|

||||

`output_dir` に学習後のモデルを保存するフォルダを指定します。`output_name` にモデルのファイル名を拡張子を除いて指定します。`save_model_as` でsafetensors形式での保存を指定しています。

|

||||

|

||||

`dataset_config` に `.toml` ファイルを指定します。ファイル内でのバッチサイズ指定は、当初はメモリ消費を抑えるために `1` としてください。

|

||||

|

||||

学習させるステップ数 `max_train_steps` を10000とします。学習率 `learning_rate` はここでは5e-6を指定しています。

|

||||

|

||||

省メモリ化のため `mixed_precision="fp16"` を指定します(RTX30 シリーズ以降では `bf16` も指定できます。環境整備時にaccelerateに行った設定と合わせてください)。また `gradient_checkpointing` を指定します。

|

||||

|

||||

オプティマイザ(モデルを学習データにあうように最適化=学習させるクラス)にメモリ消費の少ない 8bit AdamW を使うため、 `optimizer_type="AdamW8bit"` を指定します。

|

||||

|

||||

`xformers` オプションを指定し、xformersのCrossAttentionを用います。xformersをインストールしていない場合やエラーとなる場合(環境にもよりますが `mixed_precision="no"` の場合など)、代わりに `mem_eff_attn` オプションを指定すると省メモリ版CrossAttentionを使用します(速度は遅くなります)。

|

||||

|

||||

ある程度メモリがある場合は、`.toml` ファイルを編集してバッチサイズをたとえば `4` くらいに増やしてください(高速化と精度向上の可能性があります)。

|

||||

|

||||

### よく使われるオプションについて

|

||||

|

||||

以下の場合にはオプションに関するドキュメントを参照してください。

|

||||

|

||||

- Stable Diffusion 2.xまたはそこからの派生モデルを学習する

|

||||

- clip skipを2以上を前提としたモデルを学習する

|

||||

- 75トークンを超えたキャプションで学習する

|

||||

|

||||

### バッチサイズについて

|

||||

|

||||

モデル全体を学習するためLoRA等の学習に比べるとメモリ消費量は多くなります(DreamBoothと同じ)。

|

||||

|

||||

### 学習率について

|

||||

|

||||

1e-6から5e-6程度が一般的なようです。他のfine tuningの例なども参照してみてください。

|

||||

|

||||

### 以前の形式のデータセット指定をした場合のコマンドライン

|

||||

|

||||

解像度やバッチサイズをオプションで指定します。コマンドラインの例は以下の通りです。

|

||||

|

||||

```

|

||||

accelerate launch --num_cpu_threads_per_process 1 fine_tune.py

|

||||

--pretrained_model_name_or_path=model.ckpt

|

||||

@ -336,76 +115,7 @@ accelerate launch --num_cpu_threads_per_process 1 fine_tune.py

|

||||

--save_every_n_epochs=4

|

||||

```

|

||||

|

||||

accelerateのnum_cpu_threads_per_processには通常は1を指定するとよいようです。

|

||||

|

||||

pretrained_model_name_or_pathに学習対象のモデルを指定します(Stable DiffusionのcheckpointかDiffusersのモデル)。Stable Diffusionのcheckpointは.ckptと.safetensorsに対応しています(拡張子で自動判定)。

|

||||

|

||||

in_jsonにlatentをキャッシュしたときのメタデータファイルを指定します。

|

||||

|

||||

train_data_dirに教師データのフォルダを、output_dirに学習後のモデルの出力先フォルダを指定します。

|

||||

|

||||

shuffle_captionを指定すると、キャプション、タグをカンマ区切りされた単位でシャッフルして学習します(Waifu Diffusion v1.3で行っている手法です)。

|

||||

(先頭のトークンのいくつかをシャッフルせずに固定できます。その他のオプションのkeep_tokensをご覧ください。)

|

||||

|

||||

train_batch_sizeにバッチサイズを指定します。VRAM 12GBでは1か2程度を指定してください。解像度によっても指定可能な数は変わってきます。

|

||||

学習に使用される実際のデータ量は「バッチサイズ×ステップ数」です。バッチサイズを増やした時には、それに応じてステップ数を下げることが可能です。

|

||||

|

||||

learning_rateに学習率を指定します。たとえばWaifu Diffusion v1.3は5e-6のようです。

|

||||

max_train_stepsにステップ数を指定します。

|

||||

|

||||

use_8bit_adamを指定すると8-bit Adam Optimizerを使用します。省メモリ化、高速化されますが精度は下がる可能性があります。

|

||||

|

||||

xformersを指定するとCrossAttentionを置換して省メモリ化、高速化します。

|

||||

※11/9時点ではfloat32の学習ではxformersがエラーになるため、bf16/fp16を使うか、代わりにmem_eff_attnを指定して省メモリ版CrossAttentionを使ってください(速度はxformersに劣ります)。

|

||||

|

||||

gradient_checkpointingで勾配の途中保存を有効にします。速度は遅くなりますが使用メモリ量が減ります。

|

||||

|

||||

mixed_precisionで混合精度を使うか否かを指定します。"fp16"または"bf16"を指定すると省メモリになりますが精度は劣ります。

|

||||

"fp16"と"bf16"は使用メモリ量はほぼ同じで、bf16の方が学習結果は良くなるとの話もあります(試した範囲ではあまり違いは感じられませんでした)。

|

||||

"no"を指定すると使用しません(float32になります)。

|

||||

|

||||

※bf16で学習したcheckpointをAUTOMATIC1111氏のWeb UIで読み込むとエラーになるようです。これはデータ型のbfloat16がWeb UIのモデルsafety checkerでエラーとなるためのようです。save_precisionオプションを指定してfp16またはfloat32形式で保存してください。またはsafetensors形式で保管しても良さそうです。

|

||||

|

||||

save_every_n_epochsを指定するとそのエポックだけ経過するたびに学習中のモデルを保存します。

|

||||

|

||||

### Stable Diffusion 2.0対応

|

||||

Hugging Faceのstable-diffusion-2-baseを使う場合は--v2オプションを、stable-diffusion-2または768-v-ema.ckptを使う場合は--v2と--v_parameterizationの両方のオプションを指定してください。

|

||||

|

||||

### メモリに余裕がある場合に精度や速度を上げる

|

||||

まずgradient_checkpointingを外すと速度が上がります。ただし設定できるバッチサイズが減りますので、精度と速度のバランスを見ながら設定してください。

|

||||

|

||||

バッチサイズを増やすと速度、精度が上がります。メモリが足りる範囲で、1データ当たりの速度を確認しながら増やしてください(メモリがぎりぎりになるとかえって速度が落ちることがあります)。

|

||||

|

||||

### 使用するCLIP出力の変更

|

||||

clip_skipオプションに2を指定すると、後ろから二番目の層の出力を用います。1またはオプション省略時は最後の層を用います。

|

||||

学習したモデルはAutomatic1111氏のWeb UIで推論できるはずです。

|

||||

|

||||

※SD2.0はデフォルトで後ろから二番目の層を使うため、SD2.0の学習では指定しないでください。

|

||||

|

||||

学習対象のモデルがもともと二番目の層を使うように学習されている場合は、2を指定するとよいでしょう。

|

||||

|

||||

そうではなく最後の層を使用していた場合はモデル全体がそれを前提に学習されています。そのため改めて二番目の層を使用して学習すると、望ましい学習結果を得るにはある程度の枚数の教師データ、長めの学習が必要になるかもしれません。

|

||||

|

||||

### トークン長の拡張

|

||||

max_token_lengthに150または225を指定することでトークン長を拡張して学習できます。

|

||||

学習したモデルはAutomatic1111氏のWeb UIで推論できるはずです。

|

||||

|

||||

clip_skipと同様に、モデルの学習状態と異なる長さで学習するには、ある程度の教師データ枚数、長めの学習時間が必要になると思われます。

|

||||

|

||||

### 学習ログの保存

|

||||

logging_dirオプションにログ保存先フォルダを指定してください。TensorBoard形式のログが保存されます。

|

||||

|

||||

たとえば--logging_dir=logsと指定すると、作業フォルダにlogsフォルダが作成され、その中の日時フォルダにログが保存されます。

|

||||

また--log_prefixオプションを指定すると、日時の前に指定した文字列が追加されます。「--logging_dir=logs --log_prefix=fine_tune_style1」などとして識別用にお使いください。

|

||||

|

||||

TensorBoardでログを確認するには、別のコマンドプロンプトを開き、作業フォルダで以下のように入力します(tensorboardはDiffusersのインストール時にあわせてインストールされると思いますが、もし入っていないならpip install tensorboardで入れてください)。

|

||||

```

|

||||

tensorboard --logdir=logs

|

||||

```

|

||||

|

||||

### Hypernetworkの学習

|

||||

別の記事で解説予定です。

|

||||

|

||||

<!--

|

||||

### 勾配をfp16とした学習(実験的機能)

|

||||

full_fp16オプションを指定すると勾配を通常のfloat32からfloat16(fp16)に変更して学習します(mixed precisionではなく完全なfp16学習になるようです)。これによりSD1.xの512*512サイズでは8GB未満、SD2.xの512*512サイズで12GB未満のVRAM使用量で学習できるようです。

|

||||

|

||||

@ -415,51 +125,16 @@ full_fp16オプションを指定すると勾配を通常のfloat32からfloat16

|

||||

(余裕があるようならtrain_batch_sizeを段階的に増やすと若干精度が上がるはずです。)

|

||||

|

||||

PyTorchのソースにパッチを当てて無理やり実現しています(PyTorch 1.12.1と1.13.0で確認)。精度はかなり落ちますし、途中で学習失敗する確率も高くなります。学習率やステップ数の設定もシビアなようです。それらを認識したうえで自己責任でお使いください。

|

||||

-->

|

||||

|

||||

### その他のオプション

|

||||

# fine tuning特有のその他の主なオプション

|

||||

|

||||

#### keep_tokens

|

||||

数値を指定するとキャプションの先頭から、指定した数だけのトークン(カンマ区切りの文字列)をシャッフルせず固定します。

|

||||

すべてのオプションについては別文書を参照してください。

|

||||

|

||||

キャプションとタグが両方ある場合、学習時のプロンプトは「キャプション,タグ1,タグ2……」のように連結されますので、「--keep_tokens=1」とすれば、学習時にキャプションが必ず先頭に来るようになります。

|

||||

|

||||

#### dataset_repeats

|

||||

データセットの枚数が極端に少ない場合、epochがすぐに終わってしまうため(epochの区切りで少し時間が掛かります)、数値を指定してデータを何倍かしてepochを長めにしてください。

|

||||

|

||||

#### train_text_encoder

|

||||

## `train_text_encoder`

|

||||

Text Encoderも学習対象とします。メモリ使用量が若干増加します。

|

||||

|

||||

通常のfine tuningではText Encoderは学習対象としませんが(恐らくText Encoderの出力に従うようにU-Netを学習するため)、学習データ数が少ない場合には、DreamBoothのようにText Encoder側に学習させるのも有効的なようです。

|

||||

|

||||

#### save_precision

|

||||

checkpoint保存時のデータ形式をfloat、fp16、bf16から指定できます(未指定時は学習中のデータ形式と同じ)。ディスク容量が節約できますがモデルによる生成結果は変わってきます。またfloatやfp16を指定すると、1111氏のWeb UIでも読めるようになるはずです。

|

||||

|

||||

※VAEについては元のcheckpointのデータ形式のままになりますので、fp16でもモデルサイズが2GB強まで小さくならない場合があります。

|

||||

|

||||

#### save_model_as

|

||||

モデルの保存形式を指定します。ckpt、safetensors、diffusers、diffusers_safetensorsのいずれかを指定してください。

|

||||

|

||||

Stable Diffusion形式(ckptまたはsafetensors)を読み込み、Diffusers形式で保存する場合、不足する情報はHugging Faceからv1.5またはv2.1の情報を落としてきて補完します。

|

||||

|

||||

#### use_safetensors

|

||||

このオプションを指定するとsafetensors形式でcheckpointを保存します。保存形式はデフォルト(読み込んだ形式と同じ)になります。

|

||||

|

||||

#### save_stateとresume

|

||||

save_stateオプションで、途中保存時および最終保存時に、checkpointに加えてoptimizer等の学習状態をフォルダに保存します。これにより中断してから学習再開したときの精度低下が避けられます(optimizerは状態を持ちながら最適化をしていくため、その状態がリセットされると再び初期状態から最適化を行わなくてはなりません)。なお、Accelerateの仕様でステップ数は保存されません。

|

||||

|

||||

スクリプト起動時、resumeオプションで状態の保存されたフォルダを指定すると再開できます。

|

||||

|

||||

学習状態は一回の保存あたり5GB程度になりますのでディスク容量にご注意ください。

|

||||

|

||||

#### gradient_accumulation_steps

|

||||

指定したステップ数だけまとめて勾配を更新します。バッチサイズを増やすのと同様の効果がありますが、メモリを若干消費します。

|

||||

|

||||

※Accelerateの仕様で学習モデルが複数の場合には対応していないとのことですので、Text Encoderを学習対象にして、このオプションに2以上の値を指定するとエラーになるかもしれません。

|

||||

|

||||

#### lr_scheduler / lr_warmup_steps

|

||||

lr_schedulerオプションで学習率のスケジューラをlinear, cosine, cosine_with_restarts, polynomial, constant, constant_with_warmupから選べます。デフォルトはconstantです。

|

||||

|

||||

lr_warmup_stepsでスケジューラのウォームアップ(だんだん学習率を変えていく)ステップ数を指定できます。詳細については各自お調べください。

|

||||

|

||||

#### diffusers_xformers

|

||||

## `diffusers_xformers`

|

||||

スクリプト独自のxformers置換機能ではなくDiffusersのxformers機能を利用します。Hypernetworkの学習はできなくなります。

|

||||

|

||||

@ -1649,10 +1649,11 @@ def get_unweighted_text_embeddings(

|

||||

if pad == eos: # v1

|

||||

text_input_chunk[:, -1] = text_input[0, -1]

|

||||

else: # v2

|

||||

if text_input_chunk[:, -1] != eos and text_input_chunk[:, -1] != pad: # 最後に普通の文字がある

|

||||

text_input_chunk[:, -1] = eos

|

||||

if text_input_chunk[:, 1] == pad: # BOSだけであとはPAD

|

||||

text_input_chunk[:, 1] = eos

|

||||

for j in range(len(text_input_chunk)):

|

||||

if text_input_chunk[j, -1] != eos and text_input_chunk[j, -1] != pad: # 最後に普通の文字がある

|

||||

text_input_chunk[j, -1] = eos

|

||||

if text_input_chunk[j, 1] == pad: # BOSだけであとはPAD

|

||||

text_input_chunk[j, 1] = eos

|

||||

|

||||

if clip_skip is None or clip_skip == 1:

|

||||

text_embedding = pipe.text_encoder(text_input_chunk)[0]

|

||||

@ -2276,13 +2277,26 @@ def main(args):

|

||||

mask_images = l

|

||||

|

||||

# 画像サイズにオプション指定があるときはリサイズする

|

||||

if init_images is not None and args.W is not None and args.H is not None:

|

||||

if args.W is not None and args.H is not None:

|

||||

if init_images is not None:

|

||||

print(f"resize img2img source images to {args.W}*{args.H}")

|

||||

init_images = resize_images(init_images, (args.W, args.H))

|

||||

if mask_images is not None:

|

||||

print(f"resize img2img mask images to {args.W}*{args.H}")

|

||||

mask_images = resize_images(mask_images, (args.W, args.H))

|

||||

|

||||

if networks and mask_images:

|

||||

# mask を領域情報として流用する、現在は1枚だけ対応

|

||||

# TODO 複数のnetwork classの混在時の考慮

|

||||

print("use mask as region")

|

||||

# import cv2

|

||||

# for i in range(3):

|

||||

# cv2.imshow("msk", np.array(mask_images[0])[:,:,i])

|

||||

# cv2.waitKey()

|

||||

# cv2.destroyAllWindows()

|

||||

networks[0].__class__.set_regions(networks, np.array(mask_images[0]))

|

||||

mask_images = None

|

||||

|

||||

prev_image = None # for VGG16 guided

|

||||

if args.guide_image_path is not None:

|

||||

print(f"load image for CLIP/VGG16/ControlNet guidance: {args.guide_image_path}")

|

||||

|

||||

@ -22,6 +22,7 @@ def extract_lora(

|

||||

save_precision,

|

||||

dim,

|

||||

v2,

|

||||

conv_dim,

|

||||

):

|

||||

# Check for caption_text_input

|

||||

if model_tuned == '':

|

||||

@ -49,6 +50,8 @@ def extract_lora(

|

||||

run_cmd += f' --model_org "{model_org}"'

|

||||

run_cmd += f' --model_tuned "{model_tuned}"'

|

||||

run_cmd += f' --dim {dim}'

|

||||

if conv_dim > 0:

|

||||

run_cmd += f' --conv_dim {conv_dim}'

|

||||

if v2:

|

||||

run_cmd += f' --v2'

|

||||

|

||||

@ -71,7 +74,7 @@ def gradio_extract_lora_tab():

|

||||

gr.Markdown(

|

||||

'This utility can extract a LoRA network from a finetuned model.'

|

||||

)

|

||||

lora_ext = gr.Textbox(value='*.pt *.safetensors', visible=False)

|

||||

lora_ext = gr.Textbox(value='*.safetensors *.pt', visible=False)

|

||||

lora_ext_name = gr.Textbox(value='LoRA model types', visible=False)

|

||||

model_ext = gr.Textbox(value='*.ckpt *.safetensors', visible=False)

|

||||

model_ext_name = gr.Textbox(value='Model types', visible=False)

|

||||

@ -133,7 +136,15 @@ def gradio_extract_lora_tab():

|

||||

maximum=1024,

|

||||

label='Network Dimension',

|

||||

value=128,

|

||||

step=4,

|

||||

step=1,

|

||||

interactive=True,

|

||||

)

|

||||

conv_dim = gr.Slider(

|

||||

minimum=0,

|

||||

maximum=1024,

|

||||

label='Conv Dimension',

|

||||

value=0,

|

||||

step=1,

|

||||

interactive=True,

|

||||

)

|

||||

v2 = gr.Checkbox(label='v2', value=False, interactive=True)

|

||||

@ -142,6 +153,6 @@ def gradio_extract_lora_tab():

|

||||

|

||||

extract_button.click(

|

||||

extract_lora,

|

||||

inputs=[model_tuned, model_org, save_to, save_precision, dim, v2],

|

||||

inputs=[model_tuned, model_org, save_to, save_precision, dim, v2, conv_dim],

|

||||

show_progress=False,

|

||||

)

|

||||

|

||||

File diff suppressed because it is too large

Load Diff

@ -924,7 +924,9 @@ class FineTuningDataset(BaseDataset):

|

||||

elif tags is not None and len(tags) > 0:

|

||||

caption = caption + ', ' + tags

|

||||

tags_list.append(tags)

|

||||

assert caption is not None and len(caption) > 0, f"caption or tag is required / キャプションまたはタグは必須です:{abs_path}"

|

||||

|

||||

if caption is None:

|

||||

caption = ""

|

||||

|

||||

image_info = ImageInfo(image_key, subset.num_repeats, caption, False, abs_path)

|

||||

image_info.image_size = img_md.get('train_resolution')

|

||||

@ -2207,7 +2209,7 @@ def sample_images(accelerator, args: argparse.Namespace, epoch, steps, device, v

|

||||

if epoch is None or epoch % args.sample_every_n_epochs != 0:

|

||||

return

|

||||

else:

|

||||

if steps % args.sample_every_n_steps != 0:

|

||||

if steps % args.sample_every_n_steps != 0 or epoch is not None: # steps is not divisible or end of epoch

|

||||

return

|

||||

|

||||

print(f"generating sample images at step / サンプル画像生成 ステップ: {steps}")

|

||||

@ -2351,6 +2353,8 @@ def sample_images(accelerator, args: argparse.Namespace, epoch, steps, device, v

|

||||

if negative_prompt is not None:

|

||||

negative_prompt = negative_prompt.replace(prompt_replacement[0], prompt_replacement[1])

|

||||

|

||||

height = max(64, height - height % 8) # round to divisible by 8

|

||||

width = max(64, width - width % 8) # round to divisible by 8

|

||||

image = pipeline(prompt, height, width, sample_steps, scale, negative_prompt).images[0]

|

||||

|

||||

ts_str = time.strftime('%Y%m%d%H%M%S', time.localtime())

|

||||

|

||||

@ -21,7 +21,7 @@ def main(file):

|

||||

|

||||

for key, value in values:

|

||||

value = value.to(torch.float32)

|

||||

print(f"{key},{torch.mean(torch.abs(value))},{torch.min(torch.abs(value))}")

|

||||

print(f"{key},{str(tuple(value.size())).replace(', ', '-')},{torch.mean(torch.abs(value))},{torch.min(torch.abs(value))}")

|

||||

|

||||

|

||||

if __name__ == '__main__':

|

||||

|

||||

@ -45,8 +45,13 @@ def svd(args):

|

||||

text_encoder_t, _, unet_t = model_util.load_models_from_stable_diffusion_checkpoint(args.v2, args.model_tuned)

|

||||

|

||||

# create LoRA network to extract weights: Use dim (rank) as alpha

|

||||

lora_network_o = lora.create_network(1.0, args.dim, args.dim, None, text_encoder_o, unet_o)

|

||||

lora_network_t = lora.create_network(1.0, args.dim, args.dim, None, text_encoder_t, unet_t)

|

||||

if args.conv_dim is None:

|

||||

kwargs = {}

|

||||

else:

|

||||

kwargs = {"conv_dim": args.conv_dim, "conv_alpha": args.conv_dim}

|

||||

|

||||

lora_network_o = lora.create_network(1.0, args.dim, args.dim, None, text_encoder_o, unet_o, **kwargs)

|

||||

lora_network_t = lora.create_network(1.0, args.dim, args.dim, None, text_encoder_t, unet_t, **kwargs)

|

||||

assert len(lora_network_o.text_encoder_loras) == len(

|

||||

lora_network_t.text_encoder_loras), f"model version is different (SD1.x vs SD2.x) / それぞれのモデルのバージョンが違います(SD1.xベースとSD2.xベース) "

|

||||

|

||||

@ -85,12 +90,26 @@ def svd(args):

|

||||

|

||||

# make LoRA with svd

|

||||

print("calculating by svd")

|

||||

rank = args.dim

|

||||

lora_weights = {}

|

||||

with torch.no_grad():

|

||||

for lora_name, mat in tqdm(list(diffs.items())):

|

||||

# if args.conv_dim is None, diffs do not include LoRAs for conv2d-3x3

|

||||

conv2d = (len(mat.size()) == 4)

|

||||

kernel_size = None if not conv2d else mat.size()[2:4]

|

||||

conv2d_3x3 = conv2d and kernel_size != (1, 1)

|

||||

|

||||

rank = args.dim if not conv2d_3x3 or args.conv_dim is None else args.conv_dim

|

||||

out_dim, in_dim = mat.size()[0:2]

|

||||

|

||||

if args.device:

|

||||

mat = mat.to(args.device)

|

||||

# print(mat.size(), mat.device, rank, in_dim, out_dim)

|

||||

rank = min(rank, in_dim, out_dim) # LoRA rank cannot exceed the original dim

|

||||

|

||||

if conv2d:

|

||||

if conv2d_3x3:

|

||||

mat = mat.flatten(start_dim=1)

|

||||

else:

|

||||

mat = mat.squeeze()

|

||||

|

||||

U, S, Vh = torch.linalg.svd(mat)

|

||||

@ -102,11 +121,18 @@ def svd(args):

|

||||

Vh = Vh[:rank, :]

|

||||

|

||||

dist = torch.cat([U.flatten(), Vh.flatten()])

|

||||

hi_val = torch.quantile(dist, CLAMP_QUANTILE)

|

||||

low_val = -hi_val

|

||||

# hi_val = torch.quantile(dist, CLAMP_QUANTILE)

|

||||

# low_val = -hi_val

|

||||

|

||||

U = U.clamp(low_val, hi_val)

|

||||

Vh = Vh.clamp(low_val, hi_val)

|

||||

# U = U.clamp(low_val, hi_val)

|

||||

# Vh = Vh.clamp(low_val, hi_val)

|

||||

|

||||

if conv2d:

|

||||

U = U.reshape(out_dim, rank, 1, 1)

|

||||

Vh = Vh.reshape(rank, in_dim, kernel_size[0], kernel_size[1])

|

||||

|

||||

U = U.to("cuda").contiguous()

|

||||

Vh = Vh.to("cuda").contiguous()

|

||||

|

||||

lora_weights[lora_name] = (U, Vh)

|

||||

|

||||

@ -124,8 +150,8 @@ def svd(args):

|

||||

|

||||

weights = lora_weights[lora_name][i]

|

||||

# print(key, i, weights.size(), lora_sd[key].size())

|

||||

if len(lora_sd[key].size()) == 4:

|

||||

weights = weights.unsqueeze(2).unsqueeze(3)

|

||||

# if len(lora_sd[key].size()) == 4:

|

||||

# weights = weights.unsqueeze(2).unsqueeze(3)

|

||||

|

||||

assert weights.size() == lora_sd[key].size(), f"size unmatch: {key}"

|

||||

lora_sd[key] = weights

|

||||

@ -139,7 +165,7 @@ def svd(args):

|

||||

os.makedirs(dir_name, exist_ok=True)

|

||||

|

||||

# minimum metadata

|

||||

metadata = {"ss_network_dim": str(args.dim), "ss_network_alpha": str(args.dim)}

|

||||

metadata = {"ss_network_module": "networks.lora", "ss_network_dim": str(args.dim), "ss_network_alpha": str(args.dim)}

|

||||

|

||||

lora_network_o.save_weights(args.save_to, save_dtype, metadata)

|

||||

print(f"LoRA weights are saved to: {args.save_to}")

|

||||

@ -158,6 +184,8 @@ if __name__ == '__main__':

|

||||

parser.add_argument("--save_to", type=str, default=None,

|

||||

help="destination file name: ckpt or safetensors file / 保存先のファイル名、ckptまたはsafetensors")

|

||||

parser.add_argument("--dim", type=int, default=4, help="dimension (rank) of LoRA (default 4) / LoRAの次元数(rank)(デフォルト4)")

|

||||

parser.add_argument("--conv_dim", type=int, default=None,

|

||||

help="dimension (rank) of LoRA for Conv2d-3x3 (default None, disabled) / LoRAのConv2d-3x3の次元数(rank)(デフォルトNone、適用なし)")

|

||||

parser.add_argument("--device", type=str, default=None, help="device to use, cuda for GPU / 計算を行うデバイス、cuda でGPUを使う")

|

||||

|

||||

args = parser.parse_args()

|

||||

|

||||

@ -70,7 +70,7 @@ class LoRAModule(torch.nn.Module):

|

||||

if self.region is None:

|

||||

return self.org_forward(x) + self.lora_up(self.lora_down(x)) * self.multiplier * self.scale

|

||||

|

||||

# reginal LoRA

|

||||

# regional LoRA FIXME same as additional-network extension

|

||||

if x.size()[1] % 77 == 0:

|

||||

# print(f"LoRA for context: {self.lora_name}")

|

||||

self.region = None

|

||||

@ -107,9 +107,13 @@ def create_network(multiplier, network_dim, network_alpha, vae, text_encoder, un

|

||||

network_dim = 4 # default

|

||||

|

||||

# extract dim/alpha for conv2d, and block dim

|

||||

conv_dim = int(kwargs.get('conv_dim', network_dim))

|

||||

conv_alpha = kwargs.get('conv_alpha', network_alpha)

|

||||

if conv_alpha is not None:

|

||||

conv_dim = kwargs.get('conv_dim', None)

|

||||

conv_alpha = kwargs.get('conv_alpha', None)

|

||||

if conv_dim is not None:

|

||||

conv_dim = int(conv_dim)

|

||||

if conv_alpha is None:

|

||||

conv_alpha = 1.0

|

||||

else:

|

||||

conv_alpha = float(conv_alpha)

|

||||

|

||||

"""

|

||||

@ -165,7 +169,7 @@ def create_network_from_weights(multiplier, file, vae, text_encoder, unet, **kwa

|

||||

elif 'lora_down' in key:

|

||||

dim = value.size()[0]

|

||||

modules_dim[lora_name] = dim

|

||||

print(lora_name, value.size(), dim)

|

||||

# print(lora_name, value.size(), dim)

|

||||

|

||||

# support old LoRA without alpha

|

||||

for key in modules_dim.keys():

|

||||

|

||||

@ -48,7 +48,7 @@ def merge_to_sd_model(text_encoder, unet, models, ratios, merge_dtype):

|

||||

for name, module in root_module.named_modules():

|

||||

if module.__class__.__name__ in target_replace_modules:

|

||||

for child_name, child_module in module.named_modules():

|

||||

if child_module.__class__.__name__ == "Linear" or (child_module.__class__.__name__ == "Conv2d" and child_module.kernel_size == (1, 1)):

|

||||

if child_module.__class__.__name__ == "Linear" or child_module.__class__.__name__ == "Conv2d":

|

||||

lora_name = prefix + '.' + name + '.' + child_name

|

||||

lora_name = lora_name.replace('.', '_')

|

||||

name_to_module[lora_name] = child_module

|

||||

@ -80,13 +80,19 @@ def merge_to_sd_model(text_encoder, unet, models, ratios, merge_dtype):

|

||||

|

||||

# W <- W + U * D

|

||||

weight = module.weight

|

||||

# print(module_name, down_weight.size(), up_weight.size())

|

||||

if len(weight.size()) == 2:

|

||||

# linear

|

||||

weight = weight + ratio * (up_weight @ down_weight) * scale

|

||||

else:

|

||||

# conv2d

|

||||

elif down_weight.size()[2:4] == (1, 1):

|

||||

# conv2d 1x1

|

||||

weight = weight + ratio * (up_weight.squeeze(3).squeeze(2) @ down_weight.squeeze(3).squeeze(2)

|

||||

).unsqueeze(2).unsqueeze(3) * scale

|

||||

else:

|

||||

# conv2d 3x3

|

||||

conved = torch.nn.functional.conv2d(down_weight.permute(1, 0, 2, 3), up_weight).permute(1, 0, 2, 3)

|

||||

# print(conved.size(), weight.size(), module.stride, module.padding)

|

||||

weight = weight + ratio * conved * scale

|

||||

|

||||

module.weight = torch.nn.Parameter(weight)

|

||||

|

||||

|

||||

@ -3,11 +3,11 @@

|

||||

# Thanks to cloneofsimo and kohya

|

||||

|

||||

import argparse

|

||||

import os

|

||||

import torch

|

||||

from safetensors.torch import load_file, save_file, safe_open

|

||||

from tqdm import tqdm

|

||||

from library import train_util, model_util

|

||||

import numpy as np

|

||||

|

||||

|

||||

def load_state_dict(file_name, dtype):

|

||||

@ -38,34 +38,12 @@ def save_to_file(file_name, model, state_dict, dtype, metadata):

|

||||

torch.save(model, file_name)

|

||||

|

||||

|

||||

def index_sv_cumulative(S, target):

|

||||

original_sum = float(torch.sum(S))

|

||||

cumulative_sums = torch.cumsum(S, dim=0)/original_sum

|

||||

index = int(torch.searchsorted(cumulative_sums, target)) + 1

|

||||

if index >= len(S):

|

||||

index = len(S) - 1

|

||||

|

||||

return index

|

||||

|

||||

|

||||

def index_sv_fro(S, target):

|

||||

S_squared = S.pow(2)

|

||||

s_fro_sq = float(torch.sum(S_squared))

|

||||

sum_S_squared = torch.cumsum(S_squared, dim=0)/s_fro_sq

|

||||

index = int(torch.searchsorted(sum_S_squared, target**2)) + 1

|

||||

if index >= len(S):

|

||||

index = len(S) - 1

|

||||

|

||||

return index

|

||||

|

||||

|

||||

def resize_lora_model(lora_sd, new_rank, save_dtype, device, dynamic_method, dynamic_param, verbose):

|

||||

def resize_lora_model(lora_sd, new_rank, save_dtype, device, verbose):

|

||||

network_alpha = None

|

||||

network_dim = None

|

||||

verbose_str = "\n"

|

||||

fro_list = []

|

||||

|

||||

CLAMP_QUANTILE = 1 # 0.99

|

||||

CLAMP_QUANTILE = 0.99

|

||||

|

||||

# Extract loaded lora dim and alpha

|

||||

for key, value in lora_sd.items():

|

||||

@ -79,12 +57,9 @@ def resize_lora_model(lora_sd, new_rank, save_dtype, device, dynamic_method, dyn

|

||||

network_alpha = network_dim

|

||||

|

||||

scale = network_alpha/network_dim

|

||||

|

||||

if dynamic_method:

|

||||

print(f"Dynamically determining new alphas and dims based off {dynamic_method}: {dynamic_param}")

|

||||

else:

|

||||

new_alpha = float(scale*new_rank) # calculate new alpha from scale

|

||||

print(f"old dimension: {network_dim}, old alpha: {network_alpha}, new dim: {new_rank}, new alpha: {new_alpha}")

|

||||

|

||||

print(f"old dimension: {network_dim}, old alpha: {network_alpha}, new alpha: {new_alpha}")

|

||||

|

||||

lora_down_weight = None

|

||||

lora_up_weight = None

|

||||

@ -122,45 +97,11 @@ def resize_lora_model(lora_sd, new_rank, save_dtype, device, dynamic_method, dyn

|

||||

|

||||

U, S, Vh = torch.linalg.svd(full_weight_matrix)

|

||||

|

||||

if dynamic_method=="sv_ratio":

|

||||

# Calculate new dim and alpha based off ratio

|

||||

max_sv = S[0]

|

||||

min_sv = max_sv/dynamic_param

|

||||

new_rank = torch.sum(S > min_sv).item()

|

||||

new_rank = max(new_rank, 1)

|

||||

new_alpha = float(scale*new_rank)

|

||||

|

||||

elif dynamic_method=="sv_cumulative":

|

||||

# Calculate new dim and alpha based off cumulative sum

|

||||

new_rank = index_sv_cumulative(S, dynamic_param)

|

||||

new_rank = max(new_rank, 1)

|

||||

new_alpha = float(scale*new_rank)

|

||||

|

||||

elif dynamic_method=="sv_fro":

|

||||

# Calculate new dim and alpha based off sqrt sum of squares

|

||||

new_rank = index_sv_fro(S, dynamic_param)

|

||||

new_rank = max(new_rank, 1)

|

||||

new_alpha = float(scale*new_rank)

|

||||

|

||||

if verbose:

|

||||

s_sum = torch.sum(torch.abs(S))

|

||||

s_rank = torch.sum(torch.abs(S[:new_rank]))

|

||||

|

||||

S_squared = S.pow(2)

|

||||

s_fro = torch.sqrt(torch.sum(S_squared))

|

||||

s_red_fro = torch.sqrt(torch.sum(S_squared[:new_rank]))

|

||||

fro_percent = float(s_red_fro/s_fro)

|

||||

if not np.isnan(fro_percent):

|

||||

fro_list.append(float(fro_percent))

|

||||

|

||||

verbose_str+=f"{block_down_name:75} | "

|

||||

verbose_str+=f"sum(S) retained: {(s_rank)/s_sum:.1%}, fro retained: {fro_percent:.1%}, max(S) ratio: {S[0]/S[new_rank]:0.1f}"

|

||||

|

||||

|

||||

if verbose and dynamic_method:

|

||||

verbose_str+=f", dynamic | dim: {new_rank}, alpha: {new_alpha}\n"

|

||||

else:

|

||||

verbose_str+=f"\n"

|

||||

verbose_str+=f"{block_down_name:76} | "

|

||||

verbose_str+=f"sum(S) retained: {(s_rank)/s_sum:.1%}, max(S) ratio: {S[0]/S[new_rank]:0.1f}\n"

|

||||

|

||||

U = U[:, :new_rank]

|

||||

S = S[:new_rank]

|

||||

@ -195,8 +136,6 @@ def resize_lora_model(lora_sd, new_rank, save_dtype, device, dynamic_method, dyn

|

||||

|

||||

if verbose:

|

||||

print(verbose_str)

|

||||

|

||||

print(f"Average Frobenius norm retention: {np.mean(fro_list):.2%} | std: {np.std(fro_list):0.3f}")

|

||||

print("resizing complete")

|

||||

return o_lora_sd, network_dim, new_alpha

|

||||

|

||||

@ -212,9 +151,6 @@ def resize(args):

|

||||

return torch.bfloat16

|

||||

return None

|

||||

|

||||

if args.dynamic_method and not args.dynamic_param:

|

||||

raise Exception("If using dynamic_method, then dynamic_param is required")

|

||||

|

||||

merge_dtype = str_to_dtype('float') # matmul method above only seems to work in float32

|

||||

save_dtype = str_to_dtype(args.save_precision)

|

||||

if save_dtype is None:

|

||||

@ -224,22 +160,16 @@ def resize(args):

|

||||

lora_sd, metadata = load_state_dict(args.model, merge_dtype)

|

||||

|

||||

print("resizing rank...")

|

||||

state_dict, old_dim, new_alpha = resize_lora_model(lora_sd, args.new_rank, save_dtype, args.device, args.dynamic_method, args.dynamic_param, args.verbose)

|

||||

state_dict, old_dim, new_alpha = resize_lora_model(lora_sd, args.new_rank, save_dtype, args.device, args.verbose)

|

||||

|

||||

# update metadata

|

||||

if metadata is None:

|

||||

metadata = {}

|

||||

|

||||

comment = metadata.get("ss_training_comment", "")

|

||||

|

||||

if not args.dynamic_method:

|

||||

metadata["ss_training_comment"] = f"dimension is resized from {old_dim} to {args.new_rank}; {comment}"

|

||||

metadata["ss_network_dim"] = str(args.new_rank)

|

||||

metadata["ss_network_alpha"] = str(new_alpha)

|

||||

else:

|

||||

metadata["ss_training_comment"] = f"Dynamic resize with {args.dynamic_method}: {args.dynamic_param} from {old_dim}; {comment}"

|

||||

metadata["ss_network_dim"] = 'Dynamic'

|

||||

metadata["ss_network_alpha"] = 'Dynamic'

|

||||

|

||||

model_hash, legacy_hash = train_util.precalculate_safetensors_hashes(state_dict, metadata)

|

||||

metadata["sshs_model_hash"] = model_hash

|

||||

@ -263,11 +193,6 @@ if __name__ == '__main__':

|

||||

parser.add_argument("--device", type=str, default=None, help="device to use, cuda for GPU / 計算を行うデバイス、cuda でGPUを使う")

|

||||

parser.add_argument("--verbose", action="store_true",

|

||||

help="Display verbose resizing information / rank変更時の詳細情報を出力する")

|

||||

parser.add_argument("--dynamic_method", type=str, default=None, choices=[None, "sv_ratio", "sv_fro", "sv_cumulative"],

|

||||

help="Specify dynamic resizing method, will override --new_rank")

|

||||

parser.add_argument("--dynamic_param", type=float, default=None,

|

||||

help="Specify target for dynamic reduction")

|

||||

|

||||

|

||||

args = parser.parse_args()

|

||||

resize(args)

|

||||

@ -35,7 +35,8 @@ def save_to_file(file_name, model, state_dict, dtype):

|

||||

torch.save(model, file_name)

|

||||

|

||||

|

||||

def merge_lora_models(models, ratios, new_rank, device, merge_dtype):

|

||||

def merge_lora_models(models, ratios, new_rank, new_conv_rank, device, merge_dtype):

|

||||

print(f"new rank: {new_rank}, new conv rank: {new_conv_rank}")

|

||||

merged_sd = {}

|

||||

for model, ratio in zip(models, ratios):

|

||||

print(f"loading: {model}")

|

||||

@ -58,11 +59,12 @@ def merge_lora_models(models, ratios, new_rank, device, merge_dtype):

|

||||

in_dim = down_weight.size()[1]

|

||||

out_dim = up_weight.size()[0]

|

||||

conv2d = len(down_weight.size()) == 4

|

||||

print(lora_module_name, network_dim, alpha, in_dim, out_dim)

|

||||

kernel_size = None if not conv2d else down_weight.size()[2:4]

|

||||

# print(lora_module_name, network_dim, alpha, in_dim, out_dim, kernel_size)

|

||||

|

||||

# make original weight if not exist

|

||||

if lora_module_name not in merged_sd:

|

||||

weight = torch.zeros((out_dim, in_dim, 1, 1) if conv2d else (out_dim, in_dim), dtype=merge_dtype)

|

||||

weight = torch.zeros((out_dim, in_dim, *kernel_size) if conv2d else (out_dim, in_dim), dtype=merge_dtype)

|

||||

if device:

|

||||

weight = weight.to(device)

|

||||

else:

|

||||

@ -77,9 +79,12 @@ def merge_lora_models(models, ratios, new_rank, device, merge_dtype):

|

||||

scale = (alpha / network_dim)

|

||||

if not conv2d: # linear

|

||||

weight = weight + ratio * (up_weight @ down_weight) * scale

|

||||

else:

|

||||

elif kernel_size == (1, 1):

|

||||

weight = weight + ratio * (up_weight.squeeze(3).squeeze(2) @ down_weight.squeeze(3).squeeze(2)

|

||||

).unsqueeze(2).unsqueeze(3) * scale

|

||||

else:

|

||||

conved = torch.nn.functional.conv2d(down_weight.permute(1, 0, 2, 3), up_weight).permute(1, 0, 2, 3)

|

||||

weight = weight + ratio * conved * scale

|

||||

|

||||

merged_sd[lora_module_name] = weight

|

||||

|

||||

@ -89,16 +94,25 @@ def merge_lora_models(models, ratios, new_rank, device, merge_dtype):

|

||||

with torch.no_grad():

|

||||

for lora_module_name, mat in tqdm(list(merged_sd.items())):

|

||||

conv2d = (len(mat.size()) == 4)

|

||||

kernel_size = None if not conv2d else mat.size()[2:4]

|

||||

conv2d_3x3 = conv2d and kernel_size != (1, 1)

|

||||

out_dim, in_dim = mat.size()[0:2]

|

||||

|

||||

if conv2d:

|

||||

if conv2d_3x3:

|

||||

mat = mat.flatten(start_dim=1)

|

||||

else:

|

||||

mat = mat.squeeze()

|

||||

|

||||

module_new_rank = new_conv_rank if conv2d_3x3 else new_rank

|

||||

|

||||

U, S, Vh = torch.linalg.svd(mat)

|

||||

|

||||

U = U[:, :new_rank]

|

||||

S = S[:new_rank]

|

||||

U = U[:, :module_new_rank]

|

||||

S = S[:module_new_rank]

|

||||

U = U @ torch.diag(S)

|

||||

|

||||

Vh = Vh[:new_rank, :]

|

||||

Vh = Vh[:module_new_rank, :]

|

||||

|

||||

dist = torch.cat([U.flatten(), Vh.flatten()])

|

||||

hi_val = torch.quantile(dist, CLAMP_QUANTILE)

|

||||

@ -107,16 +121,16 @@ def merge_lora_models(models, ratios, new_rank, device, merge_dtype):

|

||||

U = U.clamp(low_val, hi_val)

|

||||

Vh = Vh.clamp(low_val, hi_val)

|

||||

|

||||

if conv2d:

|

||||

U = U.reshape(out_dim, module_new_rank, 1, 1)

|

||||

Vh = Vh.reshape(module_new_rank, in_dim, kernel_size[0], kernel_size[1])

|

||||

|

||||

up_weight = U

|

||||

down_weight = Vh

|

||||

|

||||

if conv2d:

|

||||

up_weight = up_weight.unsqueeze(2).unsqueeze(3)

|

||||

down_weight = down_weight.unsqueeze(2).unsqueeze(3)

|

||||

|

||||

merged_lora_sd[lora_module_name + '.lora_up.weight'] = up_weight.to("cpu").contiguous()

|

||||

merged_lora_sd[lora_module_name + '.lora_down.weight'] = down_weight.to("cpu").contiguous()

|

||||

merged_lora_sd[lora_module_name + '.alpha'] = torch.tensor(new_rank)

|

||||

merged_lora_sd[lora_module_name + '.alpha'] = torch.tensor(module_new_rank)

|

||||

|

||||

return merged_lora_sd

|

||||

|

||||

@ -138,7 +152,8 @@ def merge(args):

|

||||

if save_dtype is None:

|

||||

save_dtype = merge_dtype

|

||||

|

||||

state_dict = merge_lora_models(args.models, args.ratios, args.new_rank, args.device, merge_dtype)

|

||||

new_conv_rank = args.new_conv_rank if args.new_conv_rank is not None else args.new_rank

|

||||

state_dict = merge_lora_models(args.models, args.ratios, args.new_rank, new_conv_rank, args.device, merge_dtype)

|

||||

|

||||

print(f"saving model to: {args.save_to}")

|

||||

save_to_file(args.save_to, state_dict, state_dict, save_dtype)

|

||||

@ -158,6 +173,8 @@ if __name__ == '__main__':

|

||||

help="ratios for each model / それぞれのLoRAモデルの比率")

|

||||

parser.add_argument("--new_rank", type=int, default=4,

|

||||

help="Specify rank of output LoRA / 出力するLoRAのrank (dim)")

|

||||

parser.add_argument("--new_conv_rank", type=int, default=None,

|

||||

help="Specify rank of output LoRA for Conv2d 3x3, None for same as new_rank / 出力するConv2D 3x3 LoRAのrank (dim)、Noneでnew_rankと同じ")

|

||||

parser.add_argument("--device", type=str, default=None, help="device to use, cuda for GPU / 計算を行うデバイス、cuda でGPUを使う")

|

||||

|

||||

args = parser.parse_args()

|

||||

|

||||

115

tools/lycoris_locon_extract.py

Normal file

115

tools/lycoris_locon_extract.py

Normal file

@ -0,0 +1,115 @@

|

||||

import os, sys

|

||||

sys.path.insert(0, os.getcwd())

|

||||

import argparse

|

||||

|

||||

|

||||

def get_args():

|

||||

parser = argparse.ArgumentParser()

|

||||

parser.add_argument(

|

||||

"base_model", help="The model which use it to train the dreambooth model",

|

||||

default='', type=str

|

||||

)

|

||||

parser.add_argument(

|

||||

"db_model", help="the dreambooth model you want to extract the locon",

|

||||

default='', type=str

|

||||

)

|

||||

parser.add_argument(

|

||||

"output_name", help="the output model",

|

||||

default='./out.pt', type=str

|

||||

)

|

||||

parser.add_argument(

|

||||

"--is_v2", help="Your base/db model is sd v2 or not",

|

||||

default=False, action="store_true"

|

||||

)

|

||||

parser.add_argument(

|

||||

"--device", help="Which device you want to use to extract the locon",

|

||||

default='cpu', type=str

|

||||

)

|

||||

parser.add_argument(

|

||||

"--mode",

|

||||

help=(

|

||||

'extraction mode, can be "fixed", "threshold", "ratio", "quantile". '

|

||||

'If not "fixed", network_dim and conv_dim will be ignored'

|

||||

),

|

||||

default='fixed', type=str

|

||||

)

|

||||

parser.add_argument(

|

||||

"--safetensors", help='use safetensors to save locon model',

|

||||

default=False, action="store_true"

|

||||

)

|

||||

parser.add_argument(

|

||||

"--linear_dim", help="network dim for linear layer in fixed mode",

|

||||

default=1, type=int

|

||||

)

|

||||

parser.add_argument(

|

||||

"--conv_dim", help="network dim for conv layer in fixed mode",

|

||||

default=1, type=int

|

||||

)

|

||||

parser.add_argument(

|

||||

"--linear_threshold", help="singular value threshold for linear layer in threshold mode",

|

||||

default=0., type=float

|

||||

)

|

||||

parser.add_argument(

|

||||

"--conv_threshold", help="singular value threshold for conv layer in threshold mode",

|

||||

default=0., type=float

|

||||

)

|

||||

parser.add_argument(

|

||||

"--linear_ratio", help="singular ratio for linear layer in ratio mode",

|

||||

default=0., type=float

|

||||

)

|

||||

parser.add_argument(

|

||||

"--conv_ratio", help="singular ratio for conv layer in ratio mode",

|

||||

default=0., type=float

|

||||

)

|

||||

parser.add_argument(

|

||||

"--linear_quantile", help="singular value quantile for linear layer quantile mode",

|

||||

default=1., type=float

|

||||

)

|

||||

parser.add_argument(

|

||||

"--conv_quantile", help="singular value quantile for conv layer quantile mode",

|

||||

default=1., type=float

|

||||

)

|

||||

return parser.parse_args()

|

||||

ARGS = get_args()

|

||||

|

||||

|

||||

from lycoris.utils import extract_diff

|

||||

from lycoris.kohya_model_utils import load_models_from_stable_diffusion_checkpoint

|

||||

|

||||

import torch

|

||||

from safetensors.torch import save_file

|

||||

|

||||

|

||||

def main():

|

||||

args = ARGS

|

||||

base = load_models_from_stable_diffusion_checkpoint(args.is_v2, args.base_model)

|

||||

db = load_models_from_stable_diffusion_checkpoint(args.is_v2, args.db_model)

|

||||

|

||||

linear_mode_param = {

|

||||

'fixed': args.linear_dim,

|

||||

'threshold': args.linear_threshold,

|

||||

'ratio': args.linear_ratio,

|

||||

'quantile': args.linear_quantile,

|

||||

}[args.mode]

|

||||

conv_mode_param = {

|

||||

'fixed': args.conv_dim,

|

||||

'threshold': args.conv_threshold,

|

||||

'ratio': args.conv_ratio,

|

||||

'quantile': args.conv_quantile,

|

||||

}[args.mode]

|

||||

|

||||

state_dict = extract_diff(

|

||||

base, db,

|

||||

args.mode,

|

||||

linear_mode_param, conv_mode_param,

|

||||

args.device

|

||||

)

|

||||

|

||||

if args.safetensors:

|

||||

save_file(state_dict, args.output_name)

|

||||

else:

|

||||

torch.save(state_dict, args.output_name)

|

||||

|

||||

|

||||

if __name__ == '__main__':

|

||||

main()

|

||||

@ -1,4 +1,8 @@

|

||||

当リポジトリではモデルのfine tuning、DreamBooth、およびLoRAとTextual Inversionの学習をサポートします。この文書ではそれらに共通する、学習データの準備方法やスクリプトオプションについて説明します。

|

||||

__ドキュメント更新中のため記述に誤りがあるかもしれません。__

|

||||

|

||||